7.30-8.1 全数会2025(第六届)机器人及智能工厂展

火热报名中>>

英伟达“大杀器”,AI时代最强超级芯片来袭!

在最近爆火的AI热潮中,英伟达H100 GPU已成为当前进行人工智能训练的最强引擎,但就在昨日,全球图显兼AI计算霸主英伟达又放出新的大杀器——下一代GH200 Grace Hopper超级芯片,专门为加速计算和生成人工智能时代而打造!

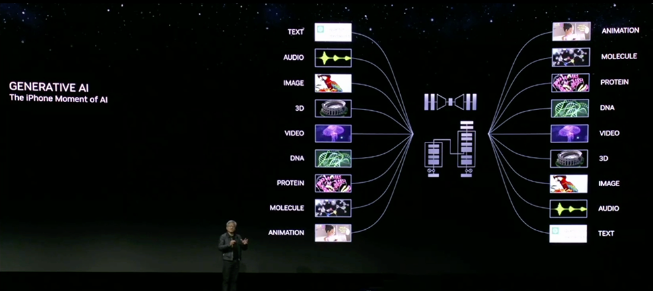

在8月8日举办的在计算机图形年会SIGGRAPH上,创始人兼CEO黄仁勋发布了多款硬件,并表示“生成式AI是AI的‘iPhone时刻’”!

(发布会视频截图)

加速计算和生成式AI时代的处理器

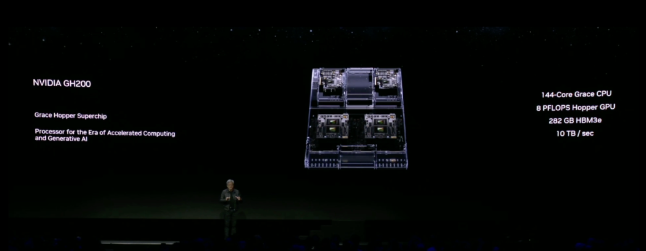

最引人注目的,便是英伟达全球首发的下一代GH200 Grace Hopper超级芯片,配备全球最快内存HBM3e,可极大降低大模型推理成本。

GH200 Grace Hopper芯片又被称为“加速计算和生成式AI时代的处理器”,该产品依赖于高带宽存储器3(即HBM3e),后者能够以每秒钟高达5TB的速度访问信息。

据悉,HBM3e是一种高带宽内存,带宽达每秒5TB。该内存比当前的HBM3快50%,可提供总共每秒10TB的组合带宽,使新平台能运行比前代大3.5倍的模型,同时通过快三倍的内存带宽提高性能。

(发布会视频截图)

值得一提的是,GH200 Grace Hopper超级芯片平台提供了卓越的内存技术和带宽,以此提高吞吐量,提升无损耗连接GPU聚合性能的能力,并且拥有可以在整个数据中心轻松部署的服务器设计。

黄仁勋表示,在AI时代,英伟达的技术可以替代传统数据中心,投资800万美元的新技术可以取代用旧设备建造的1亿美元设施,而且用电量可以减少20倍。“这就是数据中心在向加速计算转变的原因。你买的越多,越省钱。”

此外,英伟达的超大规模和高性能计算主管Ian Buck介绍,GH200比英伟达基于H100的数据中心系统配备了更多内存和带宽。它采用的英伟达的Hopper GPU,并结合基于Arm架构的英伟达Grace CPU。

相比前代平台,新GH200 Grace Hopper平台的双芯片配置将内存容量提高3.5倍,带宽增加三倍,一个服务器就有144个Arm Neoverse高性能内核、8 petaflops的AI性能和282GB的最新HBM3e内存技术。

英伟达表示,这款名为GH200的超级芯片将于2024年第二季度投产。

RTX 5000/4500/4000工作站显卡

这次,英伟达还推出了新款基于Ada Lovelace架构的桌面AI工作站GPU系列。

从今天开始,英伟达将由BOXX、戴尔、惠普和联想等合作伙伴提供全新的RTX Ada工作站解决方案。这些系统最高可配备RTX 6000 GPU。NVIDIA RTX 6000是去年发布的旗舰级Ada显卡,拥有18176个CUDA核心,48 GB GDDR6X显存,以及2.50 GHz的加速频率。可以提供91.1 TFLOPs的单精度浮点运算性能,以及1458 TFLOPs的张量运算性能。

(发布会视频截图)

除此之外,英伟达还将以更实惠的价格推出三款采用相同Ada架构的新GPU——RTX 5000、RTX 4500和RTX 4000。这些显卡都采用了台积电 4N 工艺制造,具有以下特点:

NVIDIA CUDA 内核:与上一代相比,单精度浮点吞吐量高达 2 倍。

第三代 RT 核心:相比上一代,光线追踪吞吐量提高了 2 倍,并且可以同时进行光线追踪、着色或降噪。

第四代张量核心:相比上一代,AI 训练性能提高了 2 倍,并且支持了 FP8 数据格式。

DLSS 3:借助 AI 的力量,为实时图形带来更高的真实感和交互性。

更大的显存容量:RTX 4000 提供 20 GB GDDR6 显存;RTX 4500 提供 24 GB GDDR6 显存;RTX 5000 提供 32 GB GDDR6 显存。这些显存都支持纠错码技术,可以保证处理大型 3D 模型、渲染图像、仿真和 AI 数据集时不出错。

扩展现实能力:支持高分辨率的增强现实和虚拟现实设备,为创造令人惊艳的 AR、VR 和混合现实内容提供高性能图形。

在性能方面,RTX 5000 Ada 相比 RTX A5500 提高了 3 倍;RTX 4500 相比 RTX A4500 提高了 2.7 倍;RTX 4000 相比 RTX A4000 提高了 1.7 倍。

全新NVIDIA OVX服务器

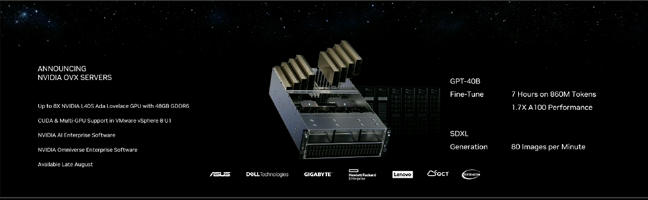

英伟达还推出了全新NVIDIA L40S GPU的NVIDIA OVX服务器,可用于加速AI训练和推理、3D设计和可视化、视频处理和工业数字化等复杂的计算密集型应用。

(发布会视频截图)

NVIDIA OVX是针对服务器的参考架构,针对图形、计算、存储和网络进行了优化。全新OVX系统将在每台服务器上启用多达8个L40S GPU,每个GPU配备48GB GDDR6超快内存。

L40S是一款功能强大的通用数据中心处理器,基于Ada架构,内置第四代Tensor Core和FP8 Transformer Engine,提供超过1.45PFLOPS的张量处理能力。

对于具有数十亿参数和多种数据模式(如文本和视频)的复杂AI工作负载,与A100 GPU相比,L40S可实现快1.2倍的AI推理性能、快1.7倍的训练性能、快3.5倍的渲染速度,启用DLSS3时Omniverse渲染速度更是能高到近4倍。

L40S包含18176个CUDA内核,提供近5倍于A100 GPU的单精度浮点(FP32)性能,以加速复杂的计算和数据密集型分析,支持对于工程和科学模拟等计算要求苛刻的工作流程。

为了支持实时渲染、产品设计和3D内容创建等高保真的专业可视化工作流程,L40S GPU内置有142个第三代RT核心,可提供212TFLOPS的光追性能。

L40S GPU将于今年秋季上市。NVIDIA之前投资的CoreWeave是首批提供L40S实例的云服务提供商之一。

图片新闻

技术文库

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

4月25日立即报名>> 【线下论坛】新唐科技2025新品发布会

-

在线会议观看回放>>> AI加速卡中村田的技术创新与趋势探讨

-

4月30日立即参与 >> 【白皮书】研华机器视觉项目召集令

-

即日-5.15立即报名>>> 【在线会议】安森美Hyperlux™ ID系列引领iToF技术革新

-

5月15日立即下载>> 【白皮书】精确和高效地表征3000V/20A功率器件应用指南

推荐专题

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论