7.30-8.1 全数会2025(第六届)机器人及智能工厂展

火热报名中>>

AMD的“硬伤”和“软肋”

在芯片界铁娘子苏姿丰的职业生涯里,有两场至关重要的战役。第一场,是在2014年接手AMD(美国超威半导体),以力挽狂澜之势让AMD从深陷财务危机到一举成为英特尔最强劲对手。

另一场则是在当下,其刚刚推出的新品AMD MI325X的内存容量相比英伟达H200提高2倍,内存带宽性能、计算性能均提升1.3倍,该芯片将于2024年第四季度上市。

那么AMD真的能成为英伟达强劲的对手吗?一起来看。

01

从业绩看

英伟达要远比AMD有吸引力

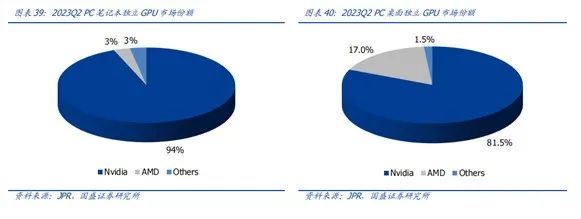

在GPU 市场份额上,目前,英伟达在AI领域处于制霸地位,它在AI处理器市场上占据超80%的份额,其高端处理器已被用于训练和运行各种聊天机器人。

从业绩看,AMD2024财年第一季度财报显示其营收为54.73亿美元,同比增长2%,环比则下降了11%;净利润为1.23亿美元,而上年同期的净亏损为1.39亿美元,相当于同比增长188%,环比则大幅下降了82%;不按照美国通用会计准则的调整后净利润为10.13亿美元,同比增长4%,环比则下降了19%。

分部门看,AMD 数据中心事业部营业额创季度新高,达23亿美元,同比增长80%,主要得益于AMD Instinct GPU和第四代AMD EPYC CPU的增长。营业额环比增长2%,主要得益于AMD Instinct GPU第一个完整的季度销售,部分抵消了服务器CPU销售的季节性下降。

客户端事业部本季度营业额为14亿美元,同比增长85%,主要得益于AMD锐龙8000系列处理器的销售增长。营业额环比下降6%。

游戏事业部本季度营业额为9.22亿美元,同比下降48%,环比下降33%,主要原因是半定制业务收入减少与AMD Radeon GPU销售下降。

嵌入式事业部本季度营业额为8.46亿美元,同比下降46%,环比下降20%,主要由于客户继续调整库存水平。

在科技行业的激烈竞争中,AMD这份财报数据并不尽如人意。虽然营收方面勉强达到了市场的预期,但在利润端,AMD却再次遭遇了大幅下滑的尴尬局面。这一结果,无疑给这家知名科技公司的未来蒙上了一层阴影。

详细剖析这份财报不难发现,即便剔除了此前收购产生的递延费用,AMD的核心经营利润也仅为4.15亿美元,环比竟下滑了45.1%。这一数字的背后,反映出的是下游需求不足的严峻现实。在这个以技术为驱动的时代,需求的疲软对于任何一家科技企业而言,都是一个不容忽视的警示信号。

与之形成对比的是英伟达2025财年的第一季度财报显示在美国通用会计准则(GAAP)下,其营收达260.4亿美元,同比增长262%,环比增长18%;净利润148.8亿美元,同比上涨628%,环比上涨21%。

而比业绩差距更明显的是市值,英伟达目前的市值(截止6月14日)收盘已经达到了3.24万亿美元,而AMD市值仅为2580亿美元,不足英伟达的十分之一。这说明华尔街对英伟达未来的预期要远远好于AMD,那么为什么同样是做GPU ,两者差距会这么大呢?

02

AMD的硬伤

英伟达的GPU更适配

首先我们来看双方目前的主流产品MI300X和H100。虽然AMD的MI300X的内存达到了192GB,但英伟达也能提供具备相同内存规格的产品,因此这不会成为绝对优势。此外AMD在与英伟达的H100对比时,不会有显著的成本优势,因为高密度的HBM价格昂贵。

并且最关键的问题在于,MI300并不具备H100所拥有的Transformer Engine。Transformer Engine能够用于加速Transformer模型,以在AI的训练和推理中以较低的内存利用率提供更好的性能。

AMD的MI300系列是目前从硬件水平上最接近H100的产品,但MI300X并没有像H100的Transformer Engine(用加速Transformer大模型的引擎),H100可以将大语言模型(LLM)的性能提高两倍,这也意味着用同样数量的MI300X将花费更长的训练时间。

Transformer Engine是英伟达H100显卡的一大亮点,专为加速Transformer网络设计。这类网络是现代AI的基础,用于处理语言理解、机器翻译等任务。H100通过其Transformer Engine,能够在保持高精度的同时,将大型语言模型的训练时间缩短至原来的一小部分。这种技术的突破为AI研究和应用带来了革命性的速度提升。

并且英伟达还在不断迭代自己的产品,不断拉开自己与AMD等公司的代差。今年3月19日,英伟达推出了全新GPU架构的Blackwell。

这款号称是“世界最强大的GPU芯片”:集成2080亿颗晶体管,采用定制4NP工艺,承袭“拼装芯片”的思路,采用统一内存架构+双芯配置,将2个受光刻模板(reticle)限制的GPU die通过10TB/s芯片间NVHyperfuse接口连一个统一GPU,共有192GB HBM3e内存、8TB/s显存带宽,单卡AI训练算力可达20PFLOPS。跟上一代Hopper相比,Blackwell因为集成了两个die,面积变大,比Hopper GPU足足多了1280亿个晶体管。对比之下,前代H100只有80GB HBM3内存、3.35TB/s带宽,H200有141GB HBM3e内存、4.8TB/s带宽。

搭载了第二代Transformer引擎:将新的微张量缩放支持和先进的动态范围管理算法与TensorRT-LLM和NeMo Megatron框架结合,使Blackwell具备在FP4精度的AI推理能力,可支持2倍的计算和模型规模,能在将性能和效率翻倍的同时保持混合专家模型的高精度。

03

AMD的软肋

英伟达CUDA有明显先发优势

英伟达除了Transformer Engine的优势外,它还通过研发开放CUDA平台统一计算架构,为开发者提供高效、易用的环境,构建庞大生态系统。举个苹果手机和IOS生态的例子:

用户使用一部苹果手机,而他必然就要使用苹果的IOS生态体系。在苹果IOS的生态体系里,APP开发者上架发布各类应用、或者买家支付都需要给苹果支付一笔生态费用,俗称“苹果税”。而Cuda平台就有点形似于GPU领域的IOS生态了,它就是通用GPU API接口,可以让不同领域的开发者访问GPU的计算资源,从而实现GPU的日常通用化。

这样一来,CUDA丰富的底层支持和软件生态服务极大降低了GPU算力调用的门槛,而在此生态中已有几百万开发者推出了各种生态服务如图形引擎、算法库及各类API接口等。

而AMD也有自己的平台即ROCm。本质上CUDA和ROCm大同小异,从芯片供应商的角度来讲,都是为了给芯片使用者或者Al的开发者,提供一个更方便使用Al芯片、异构计算的计算机模型的软件栈,都是方便用户使用他的CPU或DSA,从这个角度来看,二者解决的需求相同。

二者的区别在于CUDA推出的时间比较早,在2006年的时候,英伟达已经开始推CUDA,当时CUDA比较难用。经过了10多年的发展,2015年开始Al成为比较热门的发展方向。再加上在图形图像和并行计算领域,英伟达本身就已经是国际上最著名的公司,所以不管是高校还是企业,天然地就会选择N卡。从这个角度来讲,英伟达赶上了这一波风口浪潮,再加上CUDA做并行计算的研发时间要早很多,就带来了这种无与伦比的优势。

至于ROCm,在2015年Al浪潮兴起之后,AMD才开始做并行计算、Al计算领域的软件生态,相对来说起步更晚一些。再加上AMD的研发实力也不如英伟达强劲,所以软件栈的丰富度和好用程度相比英伟达的CUDA来说要差很多。并且AMD芯片本身的迭代速度和算力,与英伟达的迭代速度和架构变化发展相比也有不小差距。这一系列因素导致无论是AMD还是国内做GPU的芯片厂商,想用ROCm开源软件栈兼容CUDA方案去做Al技术软件栈都很困难。

04

结 语

AMD可以分到一杯羹

虽然英伟达在算力芯片上仍然具有绝对领先的地位,但AI芯片的竞争还是处在一片正在快速扩张的蓝海之中,随着AI应用越来越深入我们的生活,更加难以想象AI芯片市场的规模极限,其中留给AMD和英伟达的空间自然也足够大。英伟达尽管通过长期积累建立了强大的优势,但还有足够的市场需求等待AMD满足,这也是后者的机会所在。

- End -

原文标题 : AMD的“硬伤”和“软肋”

图片新闻

技术文库

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

4月25日立即报名>> 【线下论坛】新唐科技2025新品发布会

-

在线会议观看回放>>> AI加速卡中村田的技术创新与趋势探讨

-

4月30日立即参与 >> 【白皮书】研华机器视觉项目召集令

-

即日-5.15立即报名>>> 【在线会议】安森美Hyperlux™ ID系列引领iToF技术革新

-

5月15日立即下载>> 【白皮书】精确和高效地表征3000V/20A功率器件应用指南

推荐专题

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论